반응형

1. 핵심요약

기존의 Masked Language Modeling(MLM)

- 장점

- AR 모델과 비교했을 때, 양방향 학습이 가능

- 단점

- 전체 token 중 15%만 학습하기 때문에 지식 습득을 위해 많은 corpus가 필요 → 학습 시 Compute Cost 발생

- pre-training 할 때에는 [MASK] 토큰을 모델이 참고하여 예측하지만, fine-tuning 시 예측할때는 [MASK] 토큰을 참고하지 못함.

ELECTRA

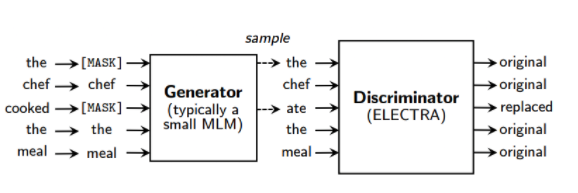

- MLM 대신 RTD(Replaced Token Detection) 이용

- generator : input을 masking 하는 대신, 실제 입력의 일부 token을 replaced token으로 바꿈

- discriminator : masking된 토큰을 예측하는 모델 대신, 각 token이 실제 입력에 있는 진짜(original) token인지 generator가 생성해낸 replaced token인지 이진 분류 (*가짜는 X → 유의어, 동의어일수 있음)

- 장점

- pre-training과 fine-tuning 사이의 [MASK] mismatch 해결

- 모든 토큰을 학습함으로 computational 효율 획득

- GAN과 비슷한 구조이나 GAN은 아님

논문 링크

https://arxiv.org/abs/2003.10555

ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators

Masked language modeling (MLM) pre-training methods such as BERT corrupt the input by replacing some tokens with [MASK] and then train a model to reconstruct the original tokens. While they produce good results when transferred to downstream NLP tasks, the

arxiv.org

설명 링크

https://coding-moomin.notion.site/ELECTRA-c69dc30a4622471dbb9202bd8ef9798b

ELECTRA

contents

coding-moomin.notion.site

반응형